Multikolinearitas merupakan masalah umum dalam analisis regresi yang terjadi ketika dua atau lebih variabel independen dalam model berkorelasi tinggi. Kehadiran multikolinearitas dapat mempersulit interpretasi koefisien regresi, karena sulit untuk menentukan efek independen dari masing-masing variabel. Akibatnya, kesalahan standar koefisien regresi cenderung meningkat, yang menyebabkan uji signifikansi menjadi kurang kuat. Hal ini dapat menyebabkan kesimpulan yang salah tentang signifikansi variabel prediktor.

Sebagai contoh, bayangkan sebuah model regresi yang bertujuan untuk memprediksi harga rumah berdasarkan ukuran rumah dan jumlah kamar tidur. Jika ukuran rumah dan jumlah kamar tidur sangat berkorelasi (rumah yang lebih besar cenderung memiliki lebih banyak kamar tidur), maka model tersebut kemungkinan akan mengalami multikolinearitas. Contoh lain adalah dalam model yang mencoba memprediksi penjualan produk berdasarkan pengeluaran iklan di televisi dan pengeluaran iklan di radio. Jika perusahaan secara konsisten mengalokasikan anggaran iklan mereka dengan proporsi yang sama antara televisi dan radio, maka kedua variabel ini akan berkorelasi tinggi.

Keberadaan multikolinearitas tidak selalu berarti model regresi tidak valid, tetapi penting untuk mengidentifikasi dan mengatasinya untuk mendapatkan hasil yang lebih akurat dan dapat diandalkan. Dampak yang paling signifikan adalah pada stabilitas dan interpretasi koefisien regresi. Model dengan multikolinearitas tinggi mungkin menghasilkan koefisien yang sangat berbeda jika data sedikit berubah, sehingga menyulitkan untuk menarik kesimpulan yang kuat tentang hubungan antara variabel independen dan dependen.

Langkah-Langkah Mengatasi Multikolinearitas

-

Identifikasi Multikolinearitas: Langkah pertama adalah mendeteksi keberadaan multikolinearitas dalam data. Ini dapat dilakukan dengan menghitung matriks korelasi antara variabel independen. Nilai korelasi yang mendekati 1 atau -1 menunjukkan adanya multikolinearitas.

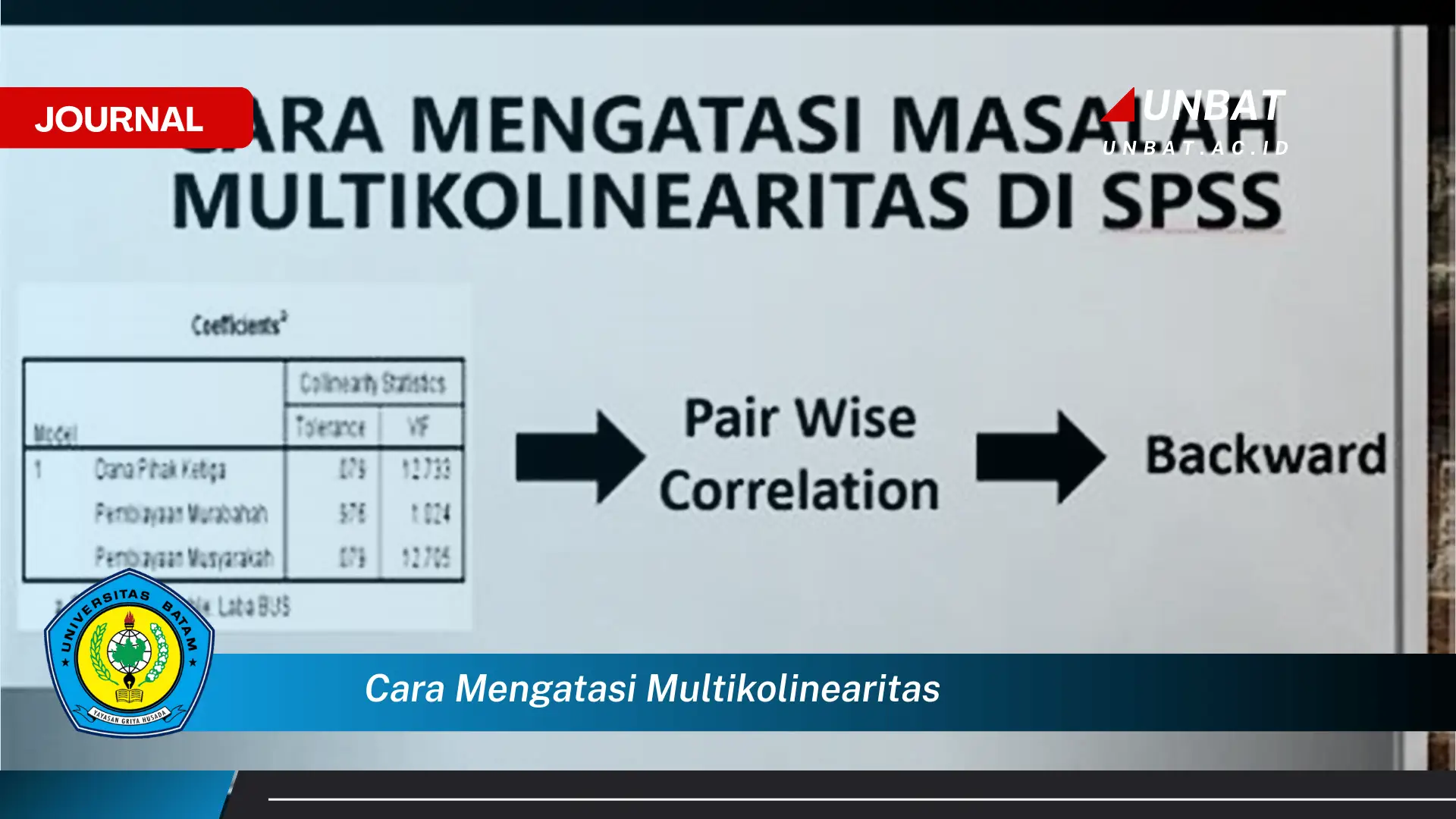

Selain matriks korelasi, Variance Inflation Factor (VIF) juga dapat digunakan. VIF mengukur seberapa besar varians dari koefisien regresi meningkat karena multikolinearitas. VIF yang lebih besar dari 5 atau 10 sering dianggap sebagai indikasi masalah multikolinearitas yang signifikan. Dengan mengidentifikasi variabel mana yang menyebabkan masalah, strategi mitigasi dapat lebih efektif diterapkan.

-

Hapus Variabel Redundan: Jika dua atau lebih variabel sangat berkorelasi, salah satu solusinya adalah dengan menghapus salah satu variabel dari model. Pilihlah variabel yang secara teoritis kurang relevan atau memiliki daya prediksi yang lebih rendah.

Keputusan untuk menghapus variabel harus didasarkan pada pertimbangan teoritis dan praktis. Pastikan variabel yang dihapus tidak memiliki peran penting dalam menjelaskan fenomena yang sedang dipelajari. Analisis lebih lanjut, seperti membandingkan kinerja model dengan dan tanpa variabel tersebut, dapat membantu dalam pengambilan keputusan.

-

Kombinasikan Variabel: Variabel yang berkorelasi dapat dikombinasikan menjadi satu variabel baru. Misalnya, jika terdapat dua variabel yang mengukur aspek yang sama, keduanya dapat dijumlahkan atau dirata-ratakan untuk menciptakan variabel komposit.

Ketika menggabungkan variabel, penting untuk memastikan bahwa variabel baru yang dihasilkan memiliki interpretasi yang jelas dan bermakna. Pertimbangkan untuk melakukan standardisasi variabel sebelum menggabungkannya, terutama jika variabel-variabel tersebut memiliki skala yang berbeda. Teknik seperti Principal Component Analysis (PCA) juga dapat digunakan untuk mengurangi dimensi data dan menciptakan variabel-variabel baru yang tidak berkorelasi.

-

Kumpulkan Lebih Banyak Data: Dalam beberapa kasus, multikolinearitas dapat dikurangi dengan mengumpulkan lebih banyak data. Dengan menambahkan lebih banyak observasi, variasi dalam data dapat meningkat, sehingga mengurangi korelasi antar variabel.

Meskipun mengumpulkan lebih banyak data dapat membantu, tidak selalu menjadi solusi yang praktis atau efektif. Biaya dan waktu yang dibutuhkan untuk mengumpulkan data tambahan perlu dipertimbangkan. Selain itu, perlu dipastikan bahwa data baru yang dikumpulkan representatif dan tidak memperkenalkan bias baru ke dalam model.

-

Gunakan Teknik Regularisasi: Teknik regularisasi, seperti regresi Ridge atau Lasso, dapat membantu mengurangi dampak multikolinearitas. Teknik ini menambahkan penalti pada model untuk mencegah koefisien regresi menjadi terlalu besar, sehingga mengurangi sensitivitas model terhadap korelasi antar variabel.

Regresi Ridge dan Lasso bekerja dengan menambahkan istilah penalti ke fungsi biaya yang diminimalkan selama proses pelatihan model. Regresi Ridge menambahkan penalti berdasarkan kuadrat dari koefisien, sedangkan Lasso menambahkan penalti berdasarkan nilai absolut dari koefisien. Lasso memiliki keunggulan tambahan yaitu dapat melakukan seleksi variabel dengan mengatur beberapa koefisien menjadi nol.

Tujuan dari solusi-solusi ini adalah untuk menghasilkan model regresi yang lebih stabil, mudah diinterpretasikan, dan memberikan prediksi yang lebih akurat. Dengan mengatasi multikolinearitas, risiko membuat kesimpulan yang salah tentang hubungan antara variabel independen dan dependen dapat diminimalkan.

Poin-Poin Penting Mengenai Multikolinearitas

| Poin | Detail |

|---|---|

| Definisi Multikolinearitas | Multikolinearitas terjadi ketika dua atau lebih variabel independen dalam model regresi berkorelasi tinggi. Korelasi yang tinggi ini menyulitkan untuk memisahkan efek individual dari masing-masing variabel terhadap variabel dependen. Hal ini dapat menyebabkan masalah dalam interpretasi koefisien regresi dan stabilitas model. |

| Dampak pada Koefisien Regresi | Multikolinearitas dapat menyebabkan koefisien regresi menjadi tidak stabil dan sulit diinterpretasikan. Koefisien mungkin berubah secara signifikan dengan sedikit perubahan dalam data. Tanda koefisien bahkan mungkin berlawanan dari yang diharapkan secara teoritis. Ini membuat sulit untuk menentukan efek sebenarnya dari variabel independen terhadap variabel dependen. |

| Pengaruh pada Uji Signifikansi | Kehadiran multikolinearitas cenderung meningkatkan kesalahan standar koefisien regresi. Akibatnya, nilai t-statistik menjadi lebih kecil, dan nilai p menjadi lebih besar. Ini membuat lebih sulit untuk menolak hipotesis nol, bahkan jika variabel tersebut sebenarnya signifikan. Oleh karena itu, uji signifikansi menjadi kurang kuat dan dapat menghasilkan kesimpulan yang salah. |

| Deteksi Multikolinearitas | Multikolinearitas dapat dideteksi menggunakan berbagai metode, termasuk matriks korelasi, Variance Inflation Factor (VIF), dan eigenvalues dari matriks korelasi. Matriks korelasi menunjukkan korelasi antar variabel independen. VIF mengukur seberapa besar varians dari koefisien regresi meningkat karena multikolinearitas. Eigenvalues yang mendekati nol juga dapat mengindikasikan adanya multikolinearitas. |

| Variance Inflation Factor (VIF) | VIF adalah ukuran seberapa besar varians dari koefisien regresi meningkat karena multikolinearitas. VIF dihitung untuk setiap variabel independen dalam model. VIF yang lebih besar dari 5 atau 10 sering dianggap sebagai indikasi masalah multikolinearitas yang signifikan. Variabel dengan VIF tinggi perlu diperhatikan dan dipertimbangkan untuk diatasi. |

| Korelasi Tinggi Bukan Satu-Satunya Indikator | Meskipun korelasi tinggi antar variabel independen merupakan indikator multikolinearitas, multikolinearitas dapat terjadi bahkan tanpa korelasi yang sangat tinggi. Ini dikenal sebagai multikolinearitas yang lebih kompleks, di mana kombinasi beberapa variabel berkorelasi dapat menyebabkan masalah. Oleh karena itu, penting untuk menggunakan beberapa metode deteksi untuk mengidentifikasi multikolinearitas. |

| Multikolinearitas Tidak Selalu Masalah | Multikolinearitas tidak selalu menjadi masalah yang serius. Jika tujuan utama adalah untuk memprediksi variabel dependen, dan bukan untuk menginterpretasikan koefisien regresi, maka multikolinearitas mungkin tidak menjadi perhatian. Namun, jika interpretasi koefisien regresi penting, maka multikolinearitas perlu diatasi. |

| Solusi Alternatif | Selain solusi yang telah disebutkan sebelumnya, terdapat solusi lain untuk mengatasi multikolinearitas, seperti menggunakan regresi komponen utama (Principal Component Regression) atau regresi parsial terkecil (Partial Least Squares Regression). Teknik-teknik ini mengubah variabel independen menjadi variabel-variabel baru yang tidak berkorelasi, sehingga mengurangi masalah multikolinearitas. |

Tips dan Detail Tambahan

- Periksa Asumsi Regresi: Sebelum mengatasi multikolinearitas, pastikan asumsi lain dari regresi linier terpenuhi, seperti linearitas, homoskedastisitas, dan independensi kesalahan. Pelanggaran terhadap asumsi-asumsi ini dapat mempengaruhi hasil regresi dan mempersulit interpretasi koefisien. Dengan memastikan asumsi-asumsi terpenuhi, model regresi akan lebih valid dan dapat diandalkan. Evaluasi residu model secara visual dan statistik untuk mendeteksi pelanggaran terhadap asumsi-asumsi ini.

- Pertimbangkan Skala Variabel: Skala variabel independen dapat mempengaruhi deteksi multikolinearitas. Variabel dengan skala yang sangat berbeda dapat menghasilkan nilai korelasi yang menyesatkan. Pertimbangkan untuk melakukan standardisasi atau normalisasi variabel sebelum menganalisis multikolinearitas. Proses ini akan memastikan bahwa semua variabel berada pada skala yang sama, sehingga mempermudah interpretasi hasil.

- Gunakan Pengetahuan Domain: Pengetahuan tentang domain masalah dapat membantu dalam mengidentifikasi dan mengatasi multikolinearitas. Memahami hubungan antar variabel secara teoritis dapat membantu dalam menentukan variabel mana yang relevan dan mana yang redundan. Pengetahuan domain juga dapat membantu dalam memilih variabel yang tepat untuk dihapus atau dikombinasikan. Berkonsultasi dengan ahli di bidang tersebut dapat memberikan wawasan berharga.

- Evaluasi Kinerja Model: Setelah mengatasi multikolinearitas, evaluasi kinerja model untuk memastikan bahwa solusi yang diterapkan efektif. Bandingkan kinerja model sebelum dan sesudah mengatasi multikolinearitas menggunakan metrik seperti R-squared, Mean Squared Error (MSE), atau Root Mean Squared Error (RMSE). Evaluasi kinerja model akan membantu dalam menentukan apakah solusi yang diterapkan telah meningkatkan akurasi dan stabilitas model.

Multikolinearitas, seperti yang telah dijelaskan, adalah fenomena yang dapat mengganggu interpretasi model regresi. Namun, penting untuk diingat bahwa mendeteksi dan mengatasi multikolinearitas hanyalah salah satu aspek dari pembangunan model yang baik. Penting untuk mempertimbangkan semua aspek dari proses pemodelan, termasuk pemilihan variabel, pengumpulan data, dan validasi model.

Dalam praktiknya, mengatasi multikolinearitas seringkali melibatkan kompromi. Menghapus variabel dari model dapat menyederhanakan model dan mengurangi multikolinearitas, tetapi juga dapat mengurangi daya prediksi model. Oleh karena itu, penting untuk mempertimbangkan trade-off antara kompleksitas model dan akurasi prediksi.

Selain itu, penting untuk mempertimbangkan tujuan dari analisis regresi. Jika tujuan utama adalah untuk memprediksi variabel dependen, maka multikolinearitas mungkin tidak menjadi perhatian utama. Namun, jika tujuan utama adalah untuk menginterpretasikan koefisien regresi, maka multikolinearitas perlu diatasi dengan hati-hati.

Teknik regularisasi, seperti regresi Ridge dan Lasso, menawarkan pendekatan yang elegan untuk mengatasi multikolinearitas. Teknik ini menambahkan penalti pada model untuk mencegah koefisien regresi menjadi terlalu besar, sehingga mengurangi sensitivitas model terhadap korelasi antar variabel. Namun, penting untuk memilih parameter regularisasi yang tepat untuk menghindari overfitting atau underfitting model.

Penting untuk diingat bahwa tidak ada solusi tunggal yang cocok untuk semua kasus multikolinearitas. Solusi terbaik akan tergantung pada karakteristik data dan tujuan dari analisis. Oleh karena itu, penting untuk bereksperimen dengan berbagai solusi dan mengevaluasi kinerja model untuk menentukan solusi yang paling efektif.

Analisis residual merupakan langkah penting dalam validasi model regresi. Residual adalah perbedaan antara nilai yang diamati dan nilai yang diprediksi oleh model. Analisis residual dapat membantu dalam mendeteksi pelanggaran terhadap asumsi regresi, seperti non-linearitas, heteroskedastisitas, atau autokorelasi.

Penggunaan perangkat lunak statistik sangat membantu dalam mengatasi multikolinearitas. Perangkat lunak statistik menyediakan berbagai alat dan fungsi untuk mendeteksi dan mengatasi multikolinearitas, seperti matriks korelasi, VIF, regresi Ridge, dan regresi Lasso. Menguasai perangkat lunak statistik akan mempermudah proses analisis regresi dan meningkatkan akurasi hasil.

Terakhir, penting untuk mendokumentasikan semua langkah yang diambil dalam mengatasi multikolinearitas. Dokumentasi yang baik akan membantu dalam mereproduksi hasil analisis dan memahami dampak dari solusi yang diterapkan. Dokumentasi juga penting untuk memastikan transparansi dan akuntabilitas dalam proses analisis.

FAQ (Frequently Asked Questions)

Pertanyaan 1 (Dari Ani): Apa saja tanda-tanda yang paling jelas bahwa model regresi saya mengalami multikolinearitas?

Jawaban (Dari Ikmah, Ahli Statistik): Beberapa tanda yang paling jelas termasuk koefisien regresi yang tidak masuk akal secara teoritis, perubahan besar dalam koefisien ketika variabel lain ditambahkan atau dihapus dari model, dan nilai Variance Inflation Factor (VIF) yang tinggi (biasanya di atas 5 atau 10). Matriks korelasi juga dapat menunjukkan korelasi tinggi antar variabel independen.

Pertanyaan 2 (Dari Budi): Jika saya menemukan multikolinearitas, apakah selalu perlu untuk menghapus variabel dari model?

Jawaban (Dari Wiki, Ahli Ekonometrika): Tidak selalu. Menghapus variabel dapat menyederhanakan model, tetapi juga dapat menghilangkan informasi penting. Pilihan lain termasuk menggabungkan variabel, mengumpulkan lebih banyak data, atau menggunakan teknik regularisasi seperti regresi Ridge atau Lasso yang secara otomatis mengurangi dampak multikolinearitas tanpa menghilangkan variabel sepenuhnya.

Pertanyaan 3 (Dari Citra): Bagaimana cara saya memutuskan variabel mana yang harus dihapus jika saya harus menghilangkan salah satunya karena multikolinearitas?

Jawaban (Dari Ikmah, Ahli Statistik): Pertimbangkan dasar teori dan signifikansi praktis dari masing-masing variabel. Pilih variabel yang kurang relevan secara teoritis atau memiliki dampak yang lebih kecil pada variabel dependen. Anda juga dapat membandingkan kinerja model dengan dan tanpa masing-masing variabel untuk melihat mana yang memberikan hasil yang lebih baik.

Pertanyaan 4 (Dari Doni): Apakah teknik regularisasi seperti Ridge dan Lasso selalu merupakan solusi yang baik untuk multikolinearitas?

Jawaban (Dari Wiki, Ahli Ekonometrika): Teknik regularisasi sangat efektif dalam mengurangi dampak multikolinearitas dan mencegah overfitting. Namun, penting untuk memilih parameter regularisasi yang tepat. Terlalu banyak regularisasi dapat menyebabkan underfitting, sementara terlalu sedikit regularisasi mungkin tidak cukup mengatasi masalah multikolinearitas. Cross-validation sering digunakan untuk memilih parameter regularisasi yang optimal.